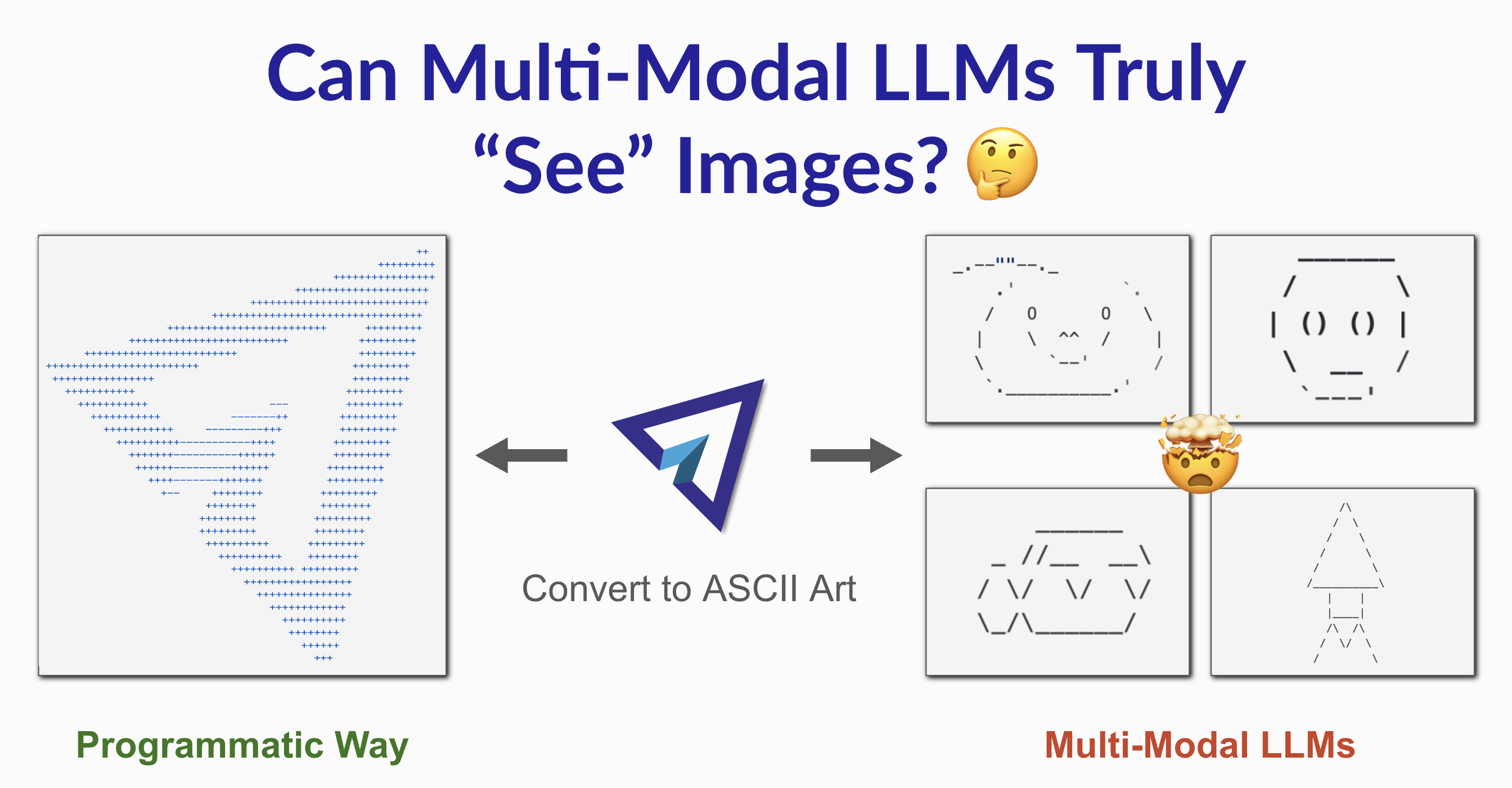

随着上周Pixtral的发布,OpenAI的GPT-4o、谷歌的Gemini Pro和Pixtral等多模态大型语言模型(LLMs)正在取得重大进展。这些模型不仅能够从图像生成文本,而且经常被宣传其“看到”图像的能力与人类感知类似。但这一说法到底有多真实呢?

更新 (2024-09-25):我为Vision Llama 3.2添加了一项新测试。不幸的是,它再次失败了。更新 (2024-09-18):我为Qwen2-VL添加了一项新测试,它仍然未能生成正确的ASCII艺术。

ASCII艺术实验

为了探索这一点,我进行了一项实验,测试模型理解简单图像空间结构并将其转换为ASCII艺术的能力。这项任务挑战了模型以文本形式解释和表达视觉细节,从而测试它们的空间推理能力。

ASCII艺术测试

我使用了一个简单的图像:SkyPilot标志。是的,有点随意,但我在编写任何云或Kubernetes上的SkyPilot部署Pixtral指南时偶然发现了它(快去看看!)。

我为每个模型使用了三个不同的提示词

- 请给出这个标志的ASCII艺术

- 以极简方式将此SkyPilot标志转换为ASCII艺术,即无背景

- 将此标志转换为ASCII艺术

这项测试主要是要求模型理解图像的空间结构,并用文本复制它。

剧透警告:对五个多模态大型语言模型进行的每次三次提示词测试中,除了其中一次尝试外,其余所有尝试都未能完全理解空间结构,也就是说,未能以ASCII艺术形式生成给定的图像。

预期输出是什么?

一个在线图像到ASCII艺术转换器生成了这项测试的预期输出:给定标志的忠实再现的ASCII版本

++

+++++++++

++++++++++++++++

+++++++++++++++++++++

++++++++++++++++++++++++++++

+++++++++++++++++++++++++++++++++

+++++++++++++++++++++++++ +++++++++

+++++++++++++++++++++++++ +++++++++

++++++++++++++++++++++++ +++++++++

++++++++++++++++++++++++ +++++++++

++++++++++++++++ +++++++++

+++++++++++ +++++++++

+++++++++++ --- +++++++++

+++++++++++ -------++ +++++++++

+++++++++++ ---------+++ +++++++++

++++++++++-----------++++ +++++++++

+++++++----------++++++ +++++++++

++++++---------++++++ +++++++++

++++-------+++++++ +++++++++

+-- ++++++++ +++++++++

++++++++ ++++++++

+++++++++ +++++++++

+++++++++ ++++++++

++++++++++ +++++++++

++++++++++ ++++++++

++++++++++ +++++++++

+++++++++++++++++

+++++++++++++++

++++++++++++

++++++++++

++++++++

++++++

+++

开源模型

Vision Llama 3.2

为了部署Vision Llama 3.2,我使用了SkyPilot Vision Llama 3.2示例中的单条命令

sky serve up -n llama3_2-vision llama3_2-vision-11b.yaml

- 尝试 1

请给出这个标志的ASCII艺术

/\

/ \

| | |

_______

|

|

- 尝试 2

以极简方式将此SkyPilot标志转换为ASCII艺术,即无背景

>>>>>>

>>>>>

>>>

- 尝试 3

将此标志转换为ASCII艺术

_____

__/ \

/ \

/ \

/____________ \

| |

| |

| |

|_______________|

Pixtral

为了部署Pixtral,我使用了SkyPilot Pixtral示例中的单条命令

sky serve up -n pixtral pixtral.yaml

- 尝试 1

请给出这个标志的ASCII艺术

____ __

/\ _`\ /\ \

\ \ \L\ __ __\ \ \_____ _____ ____

\ \ ,__\/ __/\ \ \/ / \/ / _ \/ __/

\ \ \/ /\ \ \ \ \ __ > __/\ \

\ \_\ \_\ \ \ \ \ \ \/\ \ \ \ \

\/_/ \/_/ \_\_\_\_\_\_\_\__\___\_\

- 尝试 2

以极简方式将此SkyPilot标志转换为ASCII艺术,即无背景

______

/ \

| () () |

\ __ /

`---'

- 尝试 3

将此标志转换为ASCII艺术

______

_ //__ __\

/ \/ \/ \/

\_/\______/

Qwen2-VL

为了使用SkyPilot部署Qwen2-VL,我使用了单条命令(完整示例请参见此处)

sky serve up -n qwen2 qwen2-vl-7b.yaml

- 尝试 1

请给出这个标志的ASCII艺术

____

/ \

| _ |

| | | |

| | | |

\___\/

- 尝试 2

以极简方式将此SkyPilot标志转换为ASCII艺术,即无背景

____

/ \

| _ |

| |_| |

| _ |

\___/

- 尝试 3

将此标志转换为ASCII艺术

_______

/ \

/ \

| |

\ /

\_____ _/

| | |

|_| |_| |

专有模型

专有多模态视觉-文本模型通常被认为比开源模型更强大。我们来看看它们的表现如何。

Gemini 1.5 Pro

我现在转到Google AI studio上测试谷歌的Gemini 1.5 Pro Experimental 0827,它是目前LMSYS Chatbot Arena排行榜上的顶级多模态模型。

- 尝试 1 (链接到聊天会话)

Google AI Studio截图

请给出这个标志的ASCII艺术

.....

.......

.........

...........

............

.............

...............

. .............

.. ...........

... ........

.... .......

..... .....

...... ....

....... ...

........ ..

......... .

..........

.........

.........

........

.......

......

.....

....

...

..

.

Google AI Studio截图

以极简方式将此SkyPilot标志转换为ASCII艺术,即无背景

_.--""--._

.' `.

/ O O \

| \ ^^ / |

\ `--' /

`.__________.'

Google AI Studio截图

将此标志转换为ASCII艺术

/\\

/ \\

/____\\

/______\\

/________\\

/__________\\

\__________/

\________/

\______/

\____/

\ /

\/

GPT-4o#

多模态大型语言模型最后一次大放异彩的机会,我们来试试GPT-4o。

- 尝试 1

ChatGPT 4o截图

请给出这个标志的ASCII艺术

/\

/ \

/ \

/ \

/________\

\ /

\ /

\ /

\/

- 尝试 2

ChatGPT 4o截图

以极简方式将此SkyPilot标志转换为ASCII艺术,即无背景

/\

/ \

/ \

/ \

/ \

/__________\

| |

|____|

/\ /\

/ \/ \

/ \

- 尝试 3

ChatGPT 4o截图

将此标志转换为ASCII艺术

这次模型“作弊”了,它生成了一些读取图像并以编程方式用ASCII字符替换像素的代码。它并没有真正理解空间结构。(下方,我们重新渲染了程序的输出,因为ChatGPT没有在markdown中正确显示ASCII输出。)

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@%%%%%%%%%%%%@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@%%%%%%%%%%%%@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@%%%%%%%%%%%%@@

@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@%%%%%%%%%%%%@@@

@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@

@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@

@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@

@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@

@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@

@@@%%%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@

@%%%%%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@

@@%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@

@@@%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@

@@@@%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@

@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@

@@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@

@@@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@@@@%#@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@

@@@@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@@@@@#*+#@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@

@@@@@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@@@#*+++#%@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@

@@@@@@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@%*+++++##@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@

@@@@@@@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@%*+++++++##%@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@

@@@@@@@@@@@@%%%%%%%%%%%%%@@@@@@@@@%*+++++++++###%@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@

@@@@@@@@@@@@@%%%%%%%%%%%%%@@@@@%#*++++++++++####@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@

@@@@@@@@@@@@@@%%%%%%%%%%%%%@%#*++++++++++++####%@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@

@@@@@@@@@@@@@@@%%%%%%%%%%%%*++++++++++++++#####@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@

@@@@@@@@@@@@@@@@%%%%%%%%%%#++++++++++++++######@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@

@@@@@@@@@@@@@@@@@%%%%%%%%%#+++++++++++++######%@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@

@@@@@@@@@@@@@@@@@@%%%%%%%%#++++++++++++#######@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@

@@@@@@@@@@@@@@@@@@@%%%%%%%*+++++++++++########@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@%%%%%%*++++++++++########%@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@%%%%#++++++++++#########@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@%%%#+++++++*##########%@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@%%*++++*#%@@#########%@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@%*+*#%@@@@%#########@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@#%@@@@@@@#########%@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@#########@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%#########@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@#########%@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@#########@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%########%@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@#########%@@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@##%%%%%%%%%@@@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@@@%%%%%%%%%%%%@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@@%%%%%%%%%%%%@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@%%%%%%%%%%%%@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@%%%%%%%%%%%%@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%%%@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%%@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%%@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%%@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%%%@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%%@@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%@@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%%@@@@@@@@@@@@@@@@@@@@

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@%%%%@@@@@@@@@@@@@@@@@@@@@

总结

多模态大型语言模型因其理解文本和图像的能力而令人印象深刻。然而,在空间推理方面,仍有很大的改进空间。

上面提到的问题可能只是另一个分词(tokenization)问题的例子,就像我们在“草莓测试”中看到的那样,但在我们看到AGI(通用人工智能)之前,还有很长的路要走。

也许OpenAI最新的o1-preview可以解决这个问题。我很高兴等待新模型支持图像。

如果您想在自己的云/集群中自托管大型语言模型进行测试,请查看SkyPilot中的一些LLM部署示例,以便在任何云或Kubernetes上运行AI。